插件(extensions)及拓展脚本(scripts)

SD-webUI为保持代码整洁和便于管理,逐步将非核心功能解耦并转为插件和拓展脚本形式提供.

下载安装及使用方法

把你想用的拓展/脚本从对应的GitHub仓库中下载下来放到webui路径下的scripts(webui启动时会从中加载脚本)或者extensions(webui启动时会从中加载插件)文件夹下,然后重启下webUI程序就可以开始使用.

插件

11.12 更新 近期webUI更新后 现在可以在extension选项卡下直接输入你要安装的脚本的URL(下面介绍每个插件时会给出相应的仓库链接) 然后点击安装按钮即可自动帮你去完成上面下载安装及使用方法 段落中的手动下载安装流程

![图片[1]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic4.zhimg.com/80/v2-35bf16f21ef03a52b81c6a4128cbc34f_720w.webp)

![图片[2]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic2.zhimg.com/80/v2-196a37b2b36233318f389083730498dd_720w.webp)

Dreambooth

dreambooth自训练现在可以在webUI里完成(作者就是曾经提交pr想要将dreambooth merge到webui主体里的那个大佬,随着webui规模不断庞大,原来的pr合并到主仓库变得不怎么现实,所以作者经过一段时间开发和完善 转而以extension形式提供dreambooth自训练的功能 )

插件地址: GitHub – d8ahazard/sd_dreambooth_extension

还是不推荐使用Dreambooth插件 插件所需好多依赖与webui本身有很多冲突 很容易崩 !!!

还是推荐基于diffuser库封装的方式 具体教程见下

![图片[4]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic2.zhimg.com/80/v2-c01564b6d83fe0e2c5d7ad4a140d7555_720w.webp)

aesthetic-gradients(根据美学权重优化图片)

![图片[5]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic1.zhimg.com/80/v2-04607b0b575a0ff28e4d1c5a356839fc_720w.webp)

images-browser(历史记录画廊、原来是webui自带的)

Deforum(输入:文本/图像/视频 生成 2D/3D动画)

aesthetic-image-scorer(美学评分器)

![图片[7]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-7016b26ed866b463235b988558d07986_720w.webp)

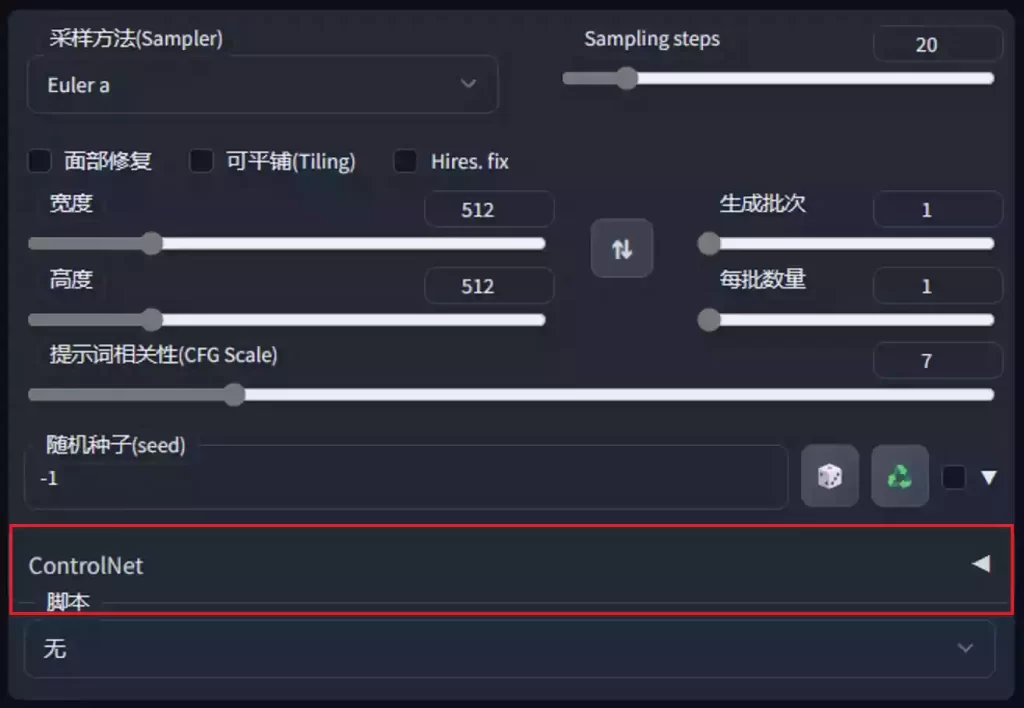

拓展脚本 scripts

使用:在txt2img 或 img2img 下底部选项里可找到脚本设置的位置

![图片[8]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic2.zhimg.com/80/v2-ed6a8472ce46dda330caa20be124aca1_720w.webp)

所有脚本文件位置在webui下的scripts文件夹下

![图片[9]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-46d3dd180720469a0346fdf405dcf8da_720w.webp)

自身内置

loopback(回环迭代)

连续多次图生图 每次的输出是下一次的输入 可用于草图迭代和修掉画面中不需要的东西

outpainting(外绘)

Outpainting用于扩展原始图像,并对创造的空隙进行了绘画。

![图片[12]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-4f29d97237088bfd356711c30877441e_720w.webp)

X/Y plot & Prompt matrix

prompt matrix和x/y plot多用于演示,都是生成一个有好几张图组成的多格图、当你想要对比一个或多个词(艺术风格、人物细节描述等等)对最后图片的影响(prompt matrix的使用场景)亦或是一个或多个参数的不同值下(不同扩散次数、不同cfg值等等)生成的不同图片对比结果(x/y plot的使用场景)

![图片[13]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic4.zhimg.com/80/v2-f555d8ae65940ba975c20daa52fea65f_720w.webp)

需自行下载

SD Chad(美学评分器脚本版)

以上罗列了几个自己常用的或感兴趣的拓展和脚本,如需了解更多、可见官方汇总列表

webui官方插件汇总列表链接:

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Extensions

webui官方拓展脚本汇总列表链接:

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Custom-Scripts#prompt-interpolation

文章下部分是对stable-diffusion-webui的相关核心和可选依赖的汇总分析,一来是便于小伙伴们在上手webui时遇到报错时更容易定位报错的原因、二是可以更加深入webUI的内部各部分组成及作用

核心依赖(2023.1.25更新)

(部署教程中先git clone下来然后自己 pip安装本体及他们的那些相关依赖)

2023.1.25更新 现在的结构 sd (midas是深度模型使用所需的)

![图片[14]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-fa08a9c3555eb676eb42efcf75fbd7be_720w.webp.png)

几个月前旧版本的结构

![图片[15]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-d86d8531e7c286173dd1a002fd095a5a_720w.webp.jpg)

- stable-diffusion(sd本体、webUI就是封装了个UI(当然还集成了一众优秀的功能)让我们能通过可视化界面而不是通过命令行参数使用SD绘画创作)

- BLIP (interrogate CLIP的依赖 负责img2img中描述input图像内容并输入至prompt框)

- taming-transformers (stablediffusion的高分辨率图像的生成)

- k-diffusion(为SD提供samplers(采样器)SDE(随机微分方程)和ODE(常微分方程))

- midas(负责为sd 深度模型提供支持)

sd工作原理图 (详情可去下面文章阅读)

![图片[17]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-acb8546af389c14e40dfd2f7af29e8ea_720w.webp)

- webui流程图

![图片[18]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-9531a9b9a2e8be7bdcc8283093fd2d8e_720w.webp)

可选依赖全介绍及手动安装教程

(可以不装这些运行webui,直到你用到的时候再装,不过强烈建议装完省事)

- repositories路径下

- CodeFormer(程序部分)

- git clone下来然后自己 pip安装本体及他们的相关依赖

- 额外下载detection_Resnet50_Final.pth parsing_parsenet.pth两个预训练模型参数权重文件

![图片[19]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic3.zhimg.com/80/v2-d9adc5d18d98dcc3e8747e741f7c60e6_720w.webp)

- models路径下 (2023.1.25更新 ) 该路径下基本是各依赖用来存放读取各自所需的预训练模型文件

![图片[20]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic1.zhimg.com/80/v2-8e4619d8c5dcd53d3899f045a6a2bb44_720w.webp)

- CodeFormer(pth权重文件)(图片&脸部修复)

- 下载pth到对应文件夹下

- torch_deepdanbooru(现在deepdanbooru的模型读取路径)

- 把pt权重文件下到该路径即可

- deepbooru( 老黄历现在不需要了 只需准备上面torch_deepdanbooru的权重文件 deepbooru 分析图片的tag&自训练前对数据集的文本分析)

- 安装相应依赖 (注意依赖中包含tensorflow及tensorflow-io)

- github 上下载 https://github.com/KichangKim/DeepDanbooru/releases/tag/v3-20211112-sgd-e28

- 解压后放到models/deepbooru目录下即可

![图片[21]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-ad0a96485b036c4d28d0799734fb40d2_720w.webp.jpg)

- ESRGAN(图片修复)

- 下载pth到对应文件夹下

- GFPGAN(用于三次元脸部修复的GAN)

- 下载pth到对应文件夹下

- LDSR(用LDM来提升分辨率)

- 下载pth到对应文件夹下并改名为model.ckpt

- SwinIR(另一种提升分辨率的模型)

- 下载pth到对应文件夹下

- mmdet (yolo实现的自动生成蒙版的插件的依赖存放路径)

![图片[22]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](https://pic2.zhimg.com/80/v2-20f05bc8be7d9abf184092dc894678a1_720w.webp)

- VAE(见下面的文章)

- lora hypernetwork文件夹 存放lora和hypernetwork的模型文件

参考

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki

Roaming_info_for_latent_diffusion – 水铝英石

持续更新中

changlog

2023.1.25 更新现版本 各目录结构 及解释 所有所需权重文件已打包上传百度云方便大家使用

2023.1.12 stablediffusion模型探索食用指南

11.11 万众期待的dreambooth自训练现在可以在webUI里完成

拓展GitHub地址: https://github.com/d8ahazard/sd_dreambooth_extension

todo

depth2mask 插件教程

yolo自动做mask 插件教程

stylepile 插件教程

![图片[3]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-47182ae4cc323a0f21cf8f5a4459e1a3_180x120.jpg)

![图片[16]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-6bdc2f4229cfbbb179abf1e3254cfd72_180x120.jpg)

![图片[24]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-556f6d4d3646e80cc677d391a7cce2ec_180x120.jpg)

![图片[25]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-b2faeea52b2d7a2bda45cf815ff4b215_r.jpg)

![图片[27]-庖丁解牛 Stable-diffusion-webui 插件拓展及依赖汇总 - 如意-如意](http://rueee.com/wp-content/uploads/2023/03/v2-4812630bc27d642f7cafcd6cdeca3d7a.jpg)

![[赞同]](http://rueee.com/wp-content/uploads/2023/03/v2-419a1a3ed02b7cfadc20af558aabc897.png)

![[调皮]](http://rueee.com/wp-content/uploads/2023/03/v2-76c864a7fd5ddc110965657078812811.png)

![[飙泪笑]](http://rueee.com/wp-content/uploads/2023/03/v2-3bb879be3497db9051c1953cdf98def6.png) 直接搜就行

直接搜就行

暂无评论内容