(本文封面使用AI(ERINE-ViLG)生成制作,使用的文字为:「帮我做一副封面放在知乎,画中有个猫咪用电脑写代码,赛博朋克风格」)

最近这段时间,AI绘画大火。对于设计师来说,有点忧心忡忡,毕竟AI都开始威胁到自己吃饭的本领了。不过,不管打不打得过,加入AI绘画创造的队列还是明智的,这篇文章就带大家玩转AI绘画。技术原理的我会另外开一篇文章讲,这篇仅仅讲应用,如果你没有技术背景,也可以放心食用。

AI绘画都有哪些类型

1. 文本生成图像(Text2image)

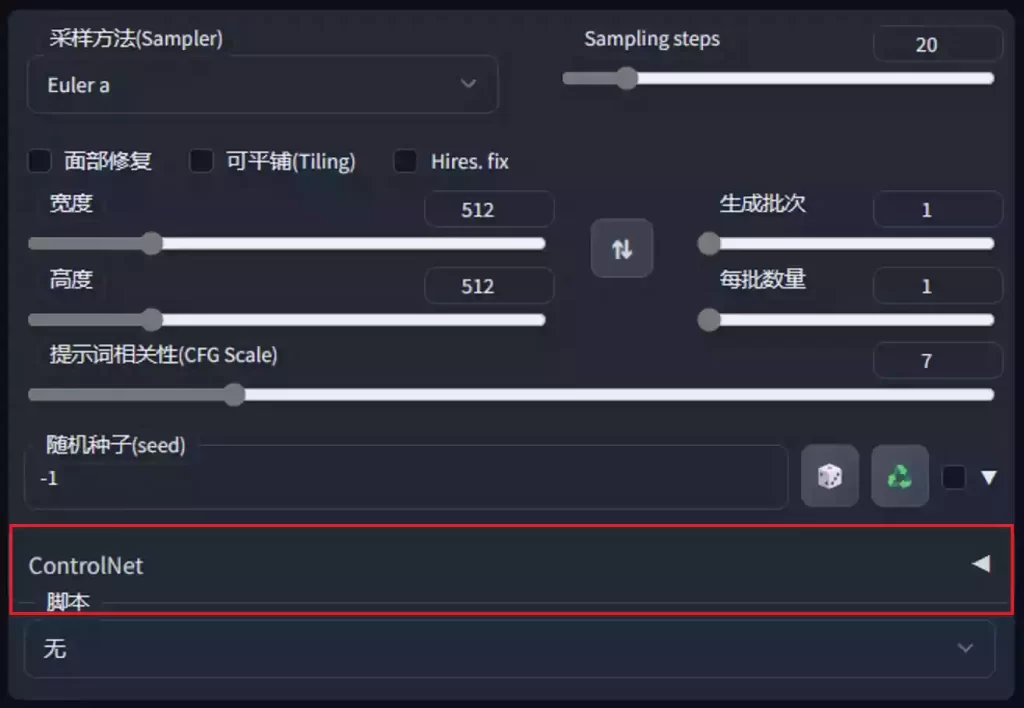

这是最近最火的类型。其中它们很多用的是diffusion model(扩散模型),有的AI模型还会加超分辨率重建模型,增强清晰度。

在使用这类模型时,你需要输入prompt,也就是你对希望产生的图像的描述。有的模型还支持初始图片,AI的会基于你指定的图片开始创作。多数是仅支持英文的,不过也有支持中文的。支持中文的我会在介绍里说到,没说到的就是只支持英文的。

这里介绍几个大家上手就能用的:

ERNIE-ViLG 文生图

这是中文领域内比较不错的文生图模型。

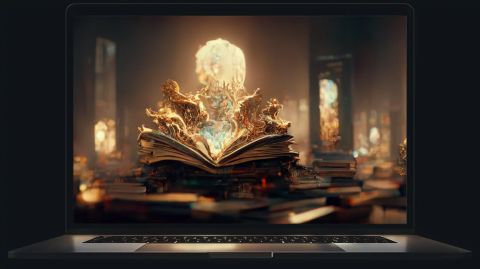

示例作品:

Midjourney:

非开源,需要你加入Discord小组给机器人发送prompt,机器人给你返回结果

这里展示用midjourney画出来的效果。对于结果,midjourney也提供超分辨率重建,提升图片清晰度。

Dream by wombo :

可以说是最简单的了,我不用介绍,大家点开就会用

画出来的效果

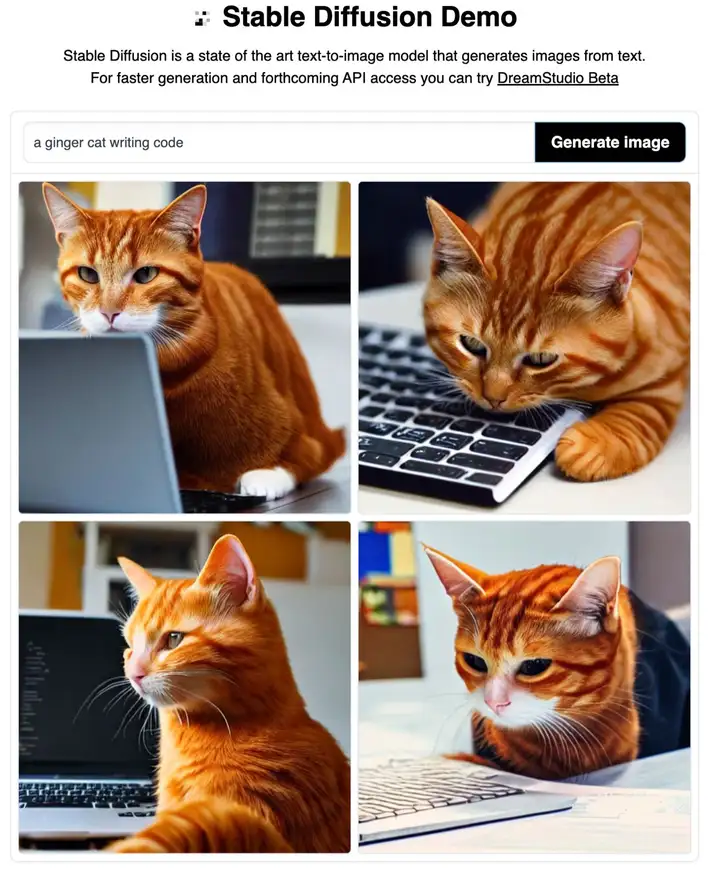

Stable Diffusion:

最近最火的绘画AI之一。在线demo:

绘画效果

源码:

Dalle-mini:

demo:

源码:

画作展示:

适合画场景

不太适合画生物

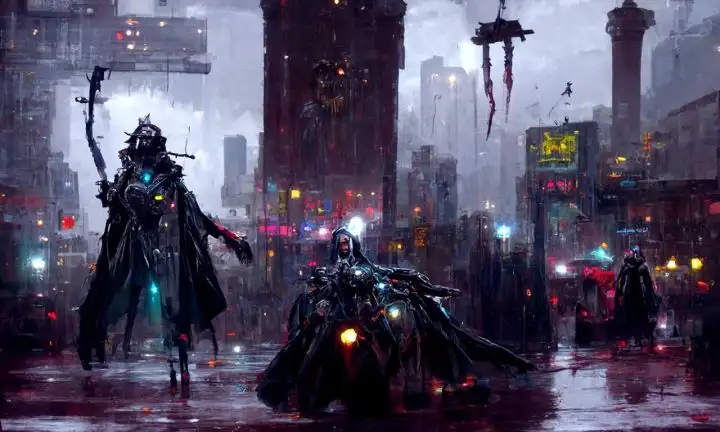

Disco Diffusion

在之前这个回答里面有详细的介绍。可以指定init_image。Disco Diffusion需要跑代码,但不一定需要看懂,你知道改哪里就行了。

我用prompt「concept art, matte painting, in the rainy streets of a cyberpunk city at night, domination of a tall dark, robot wind sorcerer with glowing eyes and a cape, artstation, Greg Rutkowski」,可以画出这样的画作

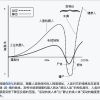

Stable Diffusion,Disco Diffusion, Dalle-mini之间的比较:

Clip-GEN

没有demo,不过提供了源码。

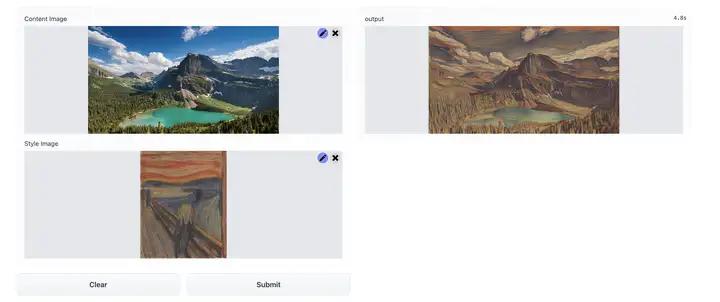

2. 风格迁移(style transfer)

风格迁移就是把图片A按照图片B的风格改画,但图片A的主体不变。

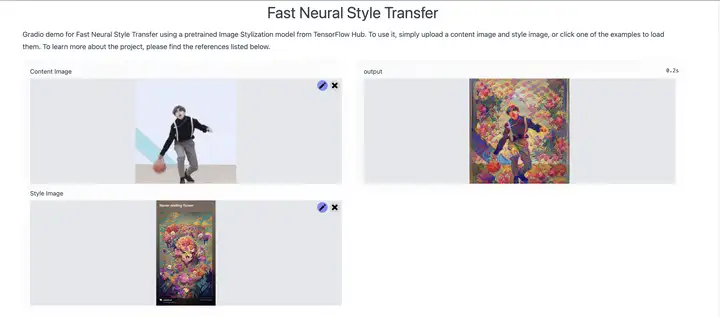

Fast Neural Style Transfer

画作参考:

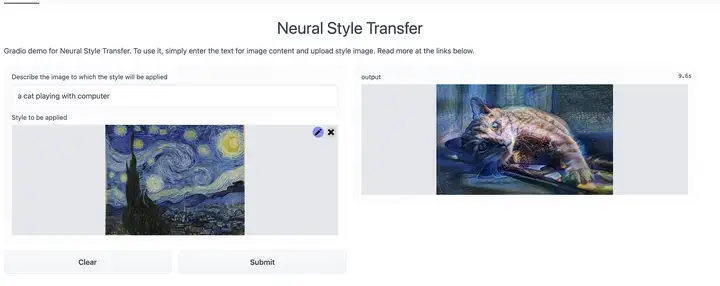

Neural Style Transfer

这个名字没起好,这个模型把前面讲到的文本生成图片和风格迁移融合在了一起。

生成结果示例:

3. 超分辨率(superresolution )/ 图片上采样(Image Upsampling)

又称图片修复,大家可以看到很多老照片修复就是用超分辨率AI修复的。这里介绍一些

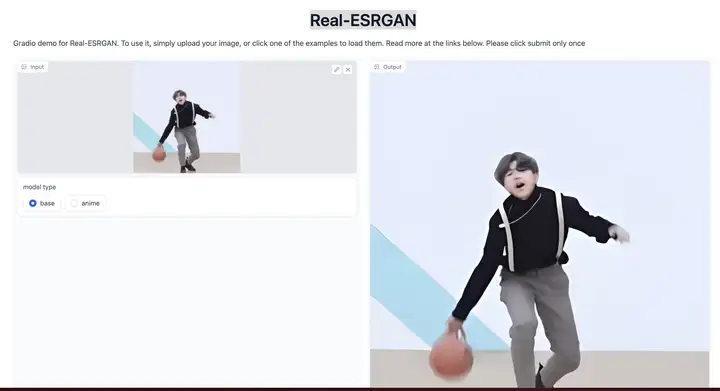

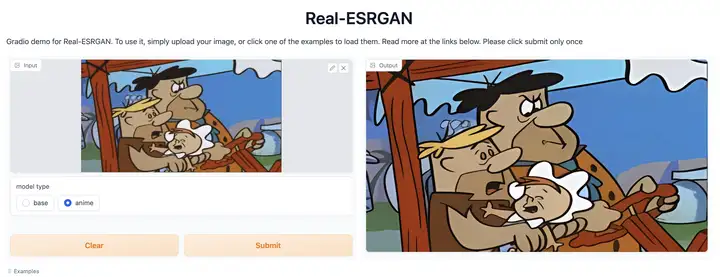

Real-ESRGAN

demo:

代码:

效果测试

看起来修复动画效果更好

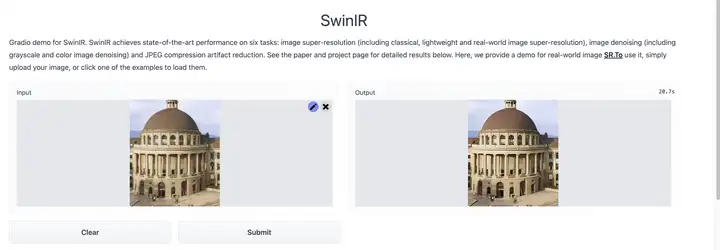

SwinIR

demo地址:

生成效果:

AI创作的思路

这里顺便讲讲我使用AI创作的思路吧。

思路一:临摹

如果仅仅给AI一个文字描述,输出的风格可能不好控制,虽然可以在文本里加一些风格的描述词,但是否感觉就是没有艺术的感觉?不要紧,直接在文本中告诉AI:

- 你需要模仿哪个网站的作品。这里总结出了一些我个人感觉很好用的网站关键词: on pixiv(日式动漫风), on artstation(科幻插画风), on 500px(摄影大片风)

- 或者模仿哪个艺术家的作品。直接在文本中加入 by xxx就行了。

例如我用prompt「a castle in the rainforest, trending on artstation」,就能画出这样的效果

这个列表提供了一些艺术家的名字及其艺术风格

这个网站可以辅助你生成prompt,包括风格,艺术家名字等等。

思路二:AI根据描述作画 -> 风格迁移-> 超分辨率

先给文本生成图像的模型一个你想要的输入,然后把输出作为超分辨率模型的输入。如果你要控制风格,你可以在文本里加一些风格的描述词。

如果风格描述依然不能打造出你想要的风格,可以试试把生成的图片输入到风格迁移AI中,产生新的图片。

如果你觉得生成的画作太模糊,可以将输出输入到超分辨率模型。

最后说说

说实话,很多时候即使你描述很具体,AI作出来的画还是和你希望得到的结果差别很大。毕竟AI生成画作不走寻常路,所以多尝试,多学习,感兴趣的甚至可以了解其背后的技术,相信你会感受到,站在艺术和科技的交叉路口是多么的有意思。

暂无评论内容